Free Statistics

of Irreproducible Research!

Description of Statistical Computation | |||||||||||||||||||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Author's title | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| Author | *The author of this computation has been verified* | ||||||||||||||||||||||||||||||||||||||||||||||||||||

| R Software Module | rwasp_edauni.wasp | ||||||||||||||||||||||||||||||||||||||||||||||||||||

| Title produced by software | Univariate Explorative Data Analysis | ||||||||||||||||||||||||||||||||||||||||||||||||||||

| Date of computation | Wed, 22 Oct 2008 06:54:15 -0600 | ||||||||||||||||||||||||||||||||||||||||||||||||||||

| Cite this page as follows | Statistical Computations at FreeStatistics.org, Office for Research Development and Education, URL https://freestatistics.org/blog/index.php?v=date/2008/Oct/22/t1224681806g7gg99neypwlq0k.htm/, Retrieved Wed, 15 May 2024 19:27:37 +0000 | ||||||||||||||||||||||||||||||||||||||||||||||||||||

| Statistical Computations at FreeStatistics.org, Office for Research Development and Education, URL https://freestatistics.org/blog/index.php?pk=18408, Retrieved Wed, 15 May 2024 19:27:37 +0000 | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| QR Codes: | |||||||||||||||||||||||||||||||||||||||||||||||||||||

|

| |||||||||||||||||||||||||||||||||||||||||||||||||||||

| Original text written by user: | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| IsPrivate? | No (this computation is public) | ||||||||||||||||||||||||||||||||||||||||||||||||||||

| User-defined keywords | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| Estimated Impact | 235 | ||||||||||||||||||||||||||||||||||||||||||||||||||||

Tree of Dependent Computations | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| Family? (F = Feedback message, R = changed R code, M = changed R Module, P = changed Parameters, D = changed Data) | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| F [Univariate Explorative Data Analysis] [Investigation Dis...] [2007-10-21 17:06:37] [b9964c45117f7aac638ab9056d451faa] F R D [Univariate Explorative Data Analysis] [q2 univariate exp...] [2008-10-22 12:54:15] [95d95b0e883740fcbc85e18ec42dcafb] [Current] F [Univariate Explorative Data Analysis] [q2 ] [2008-10-27 10:26:46] [e43247bc0ab243a5af99ac7f55ba0b41] - P [Univariate Explorative Data Analysis] [Feedback lag plot...] [2008-11-03 20:35:53] [b82ef11dce0545f3fd4676ec3ebed828] - P [Univariate Explorative Data Analysis] [Feedback lag plot...] [2008-11-03 20:57:50] [b82ef11dce0545f3fd4676ec3ebed828] - RMP [Central Tendency] [Feedback Task 1 - Q3] [2008-11-03 21:18:02] [b82ef11dce0545f3fd4676ec3ebed828] F [Univariate Explorative Data Analysis] [Q2 Univariate exp...] [2008-10-27 19:40:37] [c993f605b206b366f754f7f8c1fcc291] - P [Univariate Explorative Data Analysis] [verbetering] [2008-11-02 16:58:55] [c45c87b96bbf32ffc2144fc37d767b2e] | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| Feedback Forum | |||||||||||||||||||||||||||||||||||||||||||||||||||||

Post a new message | |||||||||||||||||||||||||||||||||||||||||||||||||||||

Dataset | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| Dataseries X: | |||||||||||||||||||||||||||||||||||||||||||||||||||||

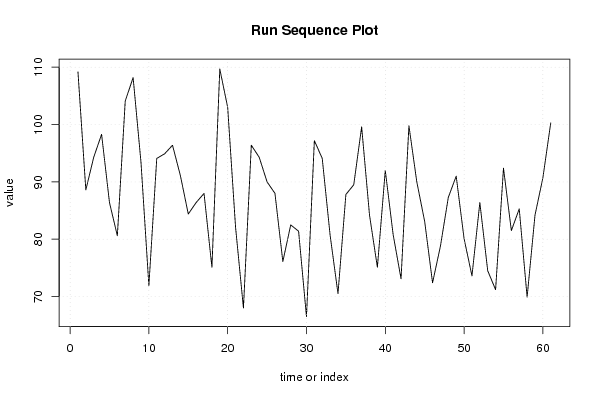

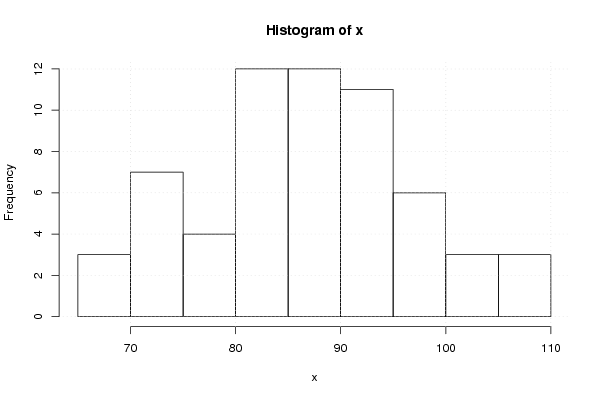

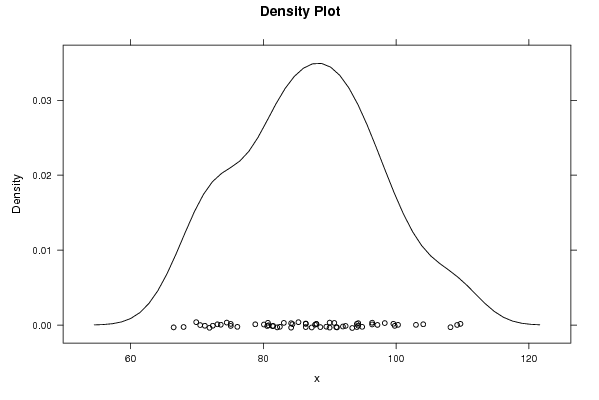

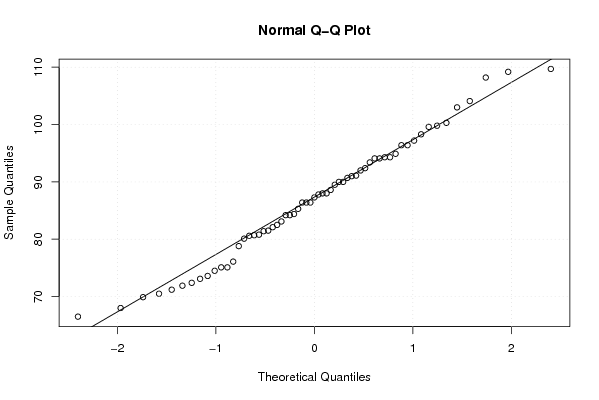

109.20 88.60 94.30 98.30 86.40 80.60 104.10 108.20 93.40 71.90 94.10 94.90 96.40 91.10 84.40 86.40 88.00 75.10 109.70 103.00 82.10 68.00 96.40 94.30 90.00 88.00 76.10 82.50 81.40 66.50 97.20 94.10 80.70 70.50 87.80 89.50 99.60 84.20 75.10 92.00 80.80 73.10 99.80 90.00 83.10 72.40 78.80 87.30 91.00 80.10 73.60 86.40 74.50 71.20 92.40 81.50 85.30 69.90 84.20 90.70 100.30 | |||||||||||||||||||||||||||||||||||||||||||||||||||||

Tables (Output of Computation) | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| |||||||||||||||||||||||||||||||||||||||||||||||||||||

Figures (Output of Computation) | |||||||||||||||||||||||||||||||||||||||||||||||||||||

Input Parameters & R Code | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| Parameters (Session): | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| par1 = 0 ; par2 = 0 ; | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| Parameters (R input): | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| par1 = 0 ; par2 = 0 ; | |||||||||||||||||||||||||||||||||||||||||||||||||||||

| R code (references can be found in the software module): | |||||||||||||||||||||||||||||||||||||||||||||||||||||

par1 <- as.numeric(par1) | |||||||||||||||||||||||||||||||||||||||||||||||||||||